La guía completa de robots.txt para WordPress

Para asegurarte de que tu sitio tenga un buen posicionamiento en las páginas de resultados de motores de búsqueda (SERP, por sus siglas en inglés), tendrás que facilitarle el trabajo a los robots del motor de búsqueda para que exploren tus páginas más importantes.

Tener un archivo robots.txt en WordPress ayudará a dirigir a esos robots hacia las páginas que quieres que se indexen y a omitir a las que no.

En este artículo, vamos a tratar:

- ¿Qué es un archivo robots.txt, y por qué es importante?

- ¿Dónde se encuentra el archivo robots.txt en WordPress?

- ¿Cómo crear un archivo robots.txt.?

- ¿Qué reglas incluir en tu archivo robots.txt de WordPress?

- ¿Cómo probar el archivo robots.txt y enviarlo a Google Search Console?

Al final de nuestro tutorial tendrás todo lo necesario para configurar un archivo robots.txt perfecto para tu sitio web de WordPress.

Descarga la hoja de trucos de WordPress definitiva

Tabla de Contenidos

¿Qué es un archivo robots.txt de WordPress?

El archivo robots.txt predeterminado de WordPress es bastante básico, pero puedes reemplazarlo fácilmente.

Cuando creas un nuevo sitio web, los motores de búsqueda envían a sus arañas (o robots rastreadores) a “rastrearlo” y crear un mapa de todas las páginas que contiene. De esta forma, sabrán qué páginas mostrar cuando alguien busque palabras clave relacionadas. En un nivel básico, es así de simple.

El problema es que los sitios web modernos contienen muchos más elementos aparte de páginas. Por ejemplo, WordPress te permite instalar plugins, que a menudo vienen con sus propios directorios. Sin embargo, no querrás que aparezcan en los resultados los motores de búsqueda, ya que no son contenido relevante.

Lo que hace el archivo robots.txt es proporcionar un conjunto de instrucciones para los robots de los motores de búsqueda. Les avisa que páginas visitar y cuáles evitar. Este archivo puede ser tan detallado como quieras y es bastante fácil de crear, incluso si no eres un experto en los aspectos técnicos.

En la práctica, los motores de búsqueda rastrearán tu sitio web, incluso si no tienes un archivo robots.txt configurado. Sin embargo, no crearlo es ineficiente. Sin este archivo, estás dejando que los robots indexen todo tu contenido y son tan minuciosos que podrían terminar mostrando partes de tu sitio web al cual no quieres que otras personas tengan acceso.

Lo que es más importante, sin un archivo robots.txt, tendrás muchos robots en tu sitio web. Esto puede afectar negativamente su rendimiento. Incluso si el contacto es insignificante, la velocidad de la página es algo que siempre debería estar entre tus principales prioridades. Después de todo los usuarios no querrán visitar un sitio web lento.

¿Dónde está ubicado el archivo robots.txt de WordPress?

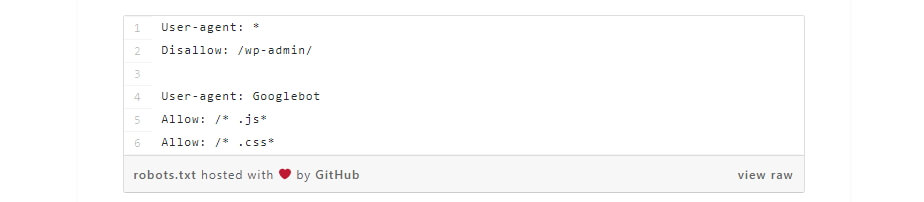

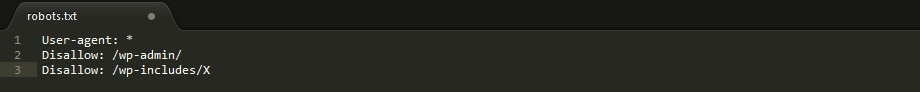

Cuando creas un sitio web de WordPress, se configura automáticamente un archivo robots.txt virtual ubicado en la carpeta principal de tu servidor. Por ejemplo, si tu sitio está ubicado en tusitioweb.com, deberías poder visitar la dirección tusitioweb.com/robots.txt y ver un archivo como este:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Este es un ejemplo de un archivo robots.txt muy básico. Para ser más directos, la parte justo después de User-agent: declara a qué robots se aplican las reglas a continuación. Un asterisco significa que las reglas son universales y se aplican a todos los robots.

En este caso, el archivo le dice a esos robots que no pueden ir a tus directorios wp-admin y wp-includes. Eso tiene cierto sentido, ya que esas dos carpetas contienen una gran cantidad de archivos confidenciales.

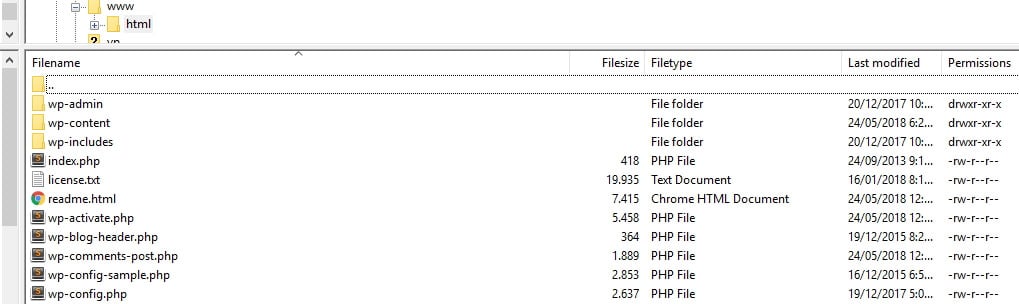

Sin embargo, es posible que quieras agregar más reglas a tu propio archivo. Antes de que puedas hacerlo, necesitarás entender que este es un archivo virtual. Por lo general, la ubicación del archivo robots.txt de WordPress está dentro de tu directorio raíz, que a menudo se denomina public_html o www (o lleva el nombre de tu sitio web):

Sin embargo, el archivo robots.txt que WordPress configura de forma predeterminada no es accesible en absoluto, desde ningún directorio. Funciona, pero si quieres realizar cambios en él, deberás crear tu propio archivo y cargarlo en tu carpeta raíz como reemplazo.

Cubriremos varias formas de crear un nuevo robots.txt para WordPress en un momento. Por ahora, hablemos sobre cómo determinar qué reglas debería incluir tu archivo.

¿Qué reglas incluir en el archivo robots.txt de WordPress?

En la sección anterior, vimos un ejemplo de un archivo robots.txt generado por WordPress. Solo incluía dos reglas cortas, pero la mayoría de los sitios web configuran más que eso. Echemos un vistazo a dos archivos robots.txt diferentes y hablemos sobre lo que cada uno hace diferente.

Aquí está nuestro primer ejemplo de robots.txt de WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: /checkout/ Disallow: /images/ Disallow: /forum/

Este es un archivo robots.txt genérico para un sitio web con un foro. Los motores de búsqueda a menudo indexan cada hilo dentro de un foro.

Sin embargo, dependiendo de para qué sea tu foro, es posible que desees rechazarlo. De esta forma, Google no indexará cientos de hilos sobre usuarios que hacen una pequeña charla. También puedes establecer reglas que indiquen sub foros específicos para evitar y permitan que los motores de búsqueda rastreen el resto.

Además verás una línea que dice Allow: / en la parte superior del archivo. Ese comando le dice a los robots que pueden rastrear todas las páginas de tu sitio web, aparte de las excepciones que estableces en seguida.

Del mismo modo, observarás que indicamos que estas reglas sean universales (con un asterisco), al igual que lo hace el archivo robots.txt virtual de WordPress.

Ahora veamos otro ejemplo de robots.txt de WordPress:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ User-agent: Bingbot Disallow: /

En este archivo, configuramos las mismas reglas que WordPress hace de forma predeterminada. Sin embargo, también agregamos un nuevo conjunto de reglas que impiden que el robot de búsqueda de Bing rastree nuestro sitio web. Bingbot, como te puedes imaginar, es el nombre de ese robot.

Puedes ser bastante específico acerca de cuáles robots de motores de búsqueda tienen acceso a tu sitio web y cuáles no. En la práctica, por supuesto, Bingbot es bastante confiable (incluso si no es tan genial como Googlebot). Sin embargo, también hay algunos robots maliciosos.

La mala noticia es que no siempre siguen las instrucciones de tu archivo robots.txt. Vale la pena tener en cuenta que, aunque la mayoría de los robots seguirán las instrucciones que des en este archivo, no los obligarás a hacerlo.

Si lees sobre el tema, encontrarás muchas sugerencias sobre qué permitir y qué bloquear en tu sitio web de WordPress. Sin embargo, en nuestra experiencia, es mejor tener pocas reglas. A continuación, se muestra un ejemplo de cómo te recomendamos que sea tu primer archivo robots.txt:

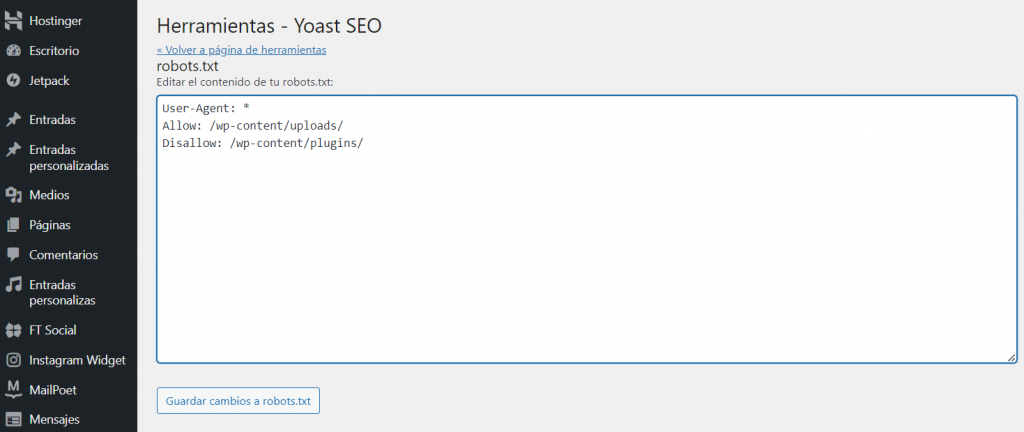

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/

Tradicionalmente, a WordPress le gusta bloquear el acceso a los directorios wp-admin y wp-includes. Sin embargo, eso ya no se considera una buena práctica. Además, si agregas metadatos a tus imágenes con fines de SEO, no tiene sentido prohibir que los robots rastreen esa información. En cambio, las dos reglas anteriores cubren lo que la mayoría de los sitios básicos requerirán.

Sin embargo, lo que incluyas en tu archivo robots.txt dependerá de tu sitio y tus necesidades específicas.

A modo de síntesis, te dejamos un resumen de la sintaxis del robots.txt:

User-agent: nombre-del-bot Directiva: contenido-de-directiva Sitemap: http://www.tudominio.com/sitemap.xml

Directivas que se pueden agregar:

- Disallow: para indicar que no quieres que el bot rastree los archivos o directorios indicados.

- Allow: para indicar que los bots sí deben rastrear este directorio.

- Crawl-delay: la espera que deben hacer los bots entre cada petición dentro del sitio.

- Noindex: especial para Google, para indicar qué archivos no quieres indexar.

Comodines que se pueden combinar:

- *: para indicar que la directiva se aplica a todos los bots.

- $: este símbolo te permite poner caracteres y hacer que los bots no indexen documentos o archivos con estos caracteres.

- #: comentarios que serán ignorados por los bots.

¿Cómo crear un archivo robots.txt en WordPress (3 métodos)?

Una vez que hayas decidido qué incluir en tu archivo robots.txt, solo falta crearlo. Puedes editar robots.txt en WordPress usando un plugin o manualmente. En esta sección, te enseñaremos a usar dos plugins populares para hacer este trabajo y analizaremos cómo crear y cargar el archivo tu mismo. ¡Vamos!

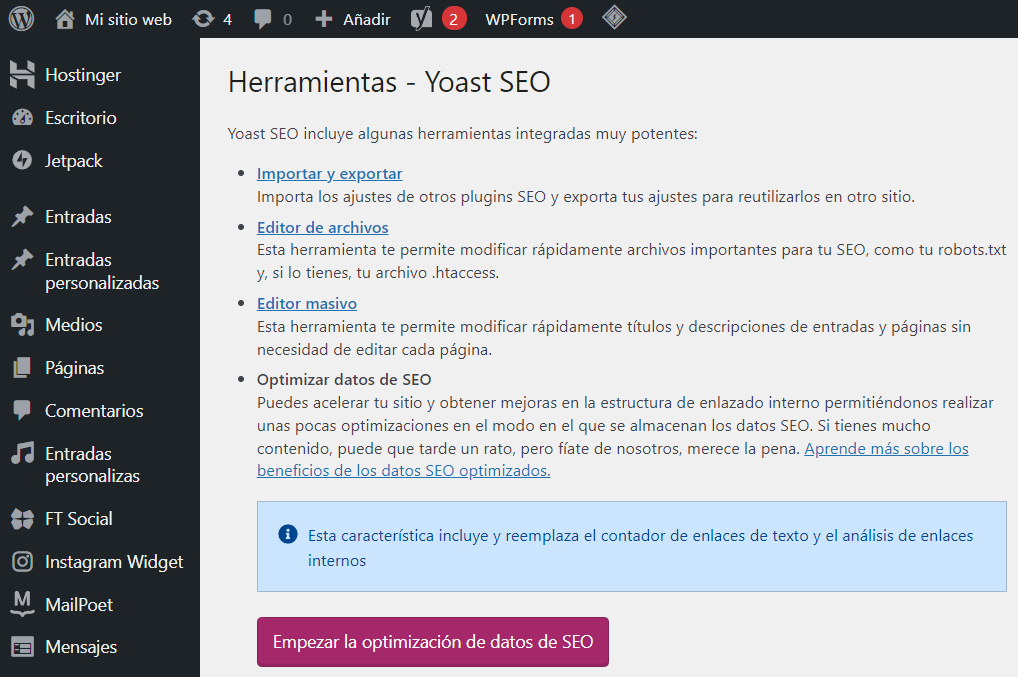

1. Yoast SEO

Yoast SEO es el plugin de SEO más popular para WordPress y te permite optimizar tus publicaciones y páginas para hacer un mejor uso de tus palabras clave. Además de eso, también te proporciona ayuda cuando se trata de aumentar la legibilidad de tu contenido, lo que significa que más personas podrán disfrutarlo.

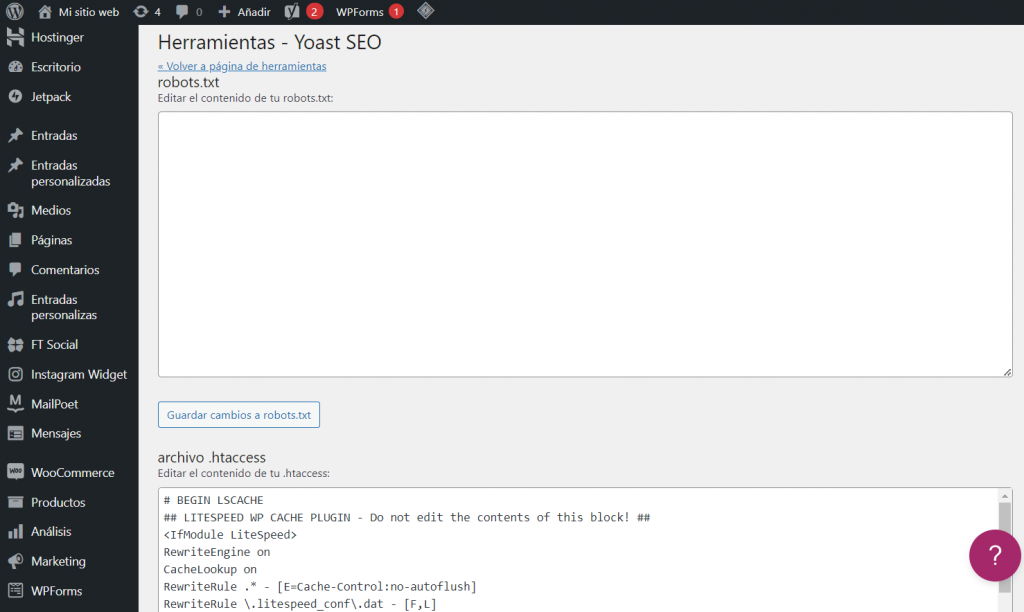

Yoast SEO es muy recomendable debido a su facilidad de uso, lo cual también se aplica a la creación de un archivo robots.txt. Una vez que instales y actives el plugin, ve a la pestaña SEO > Herramientas en tu escritorio y busca la opción que dice Editor de archivos:

Al hacer clic en ese enlace, irás a una nueva página, donde podrás editar tu archivo .htaccess sin salir de tu escritorio. También hay un botón útil con el texto Crear archivo robots.txt, el cual hace exactamente lo que dice:

Cuando hagas clic en este botón, la pestaña mostrará un nuevo editor donde podrás modificar tu archivo robots.txt directamente. Ten en cuenta que Yoast SEO establece sus propias reglas predeterminadas, que anulan tu archivo robots.txt virtual existente.

Cada vez que agregues o elimines reglas, recuerda hacer clic en el botón Guardar cambios en robots.txt, para que se apliquen:

2. Plugin All in One SEO Pack

All in One SEO Pack es otro nombre conocido cuando se trata de SEO en WordPress. Incluye la mayoría de las funciones que ofrece Yoast SEO, pero algunas personas lo prefieren porque es un plugin más liviano. En cuanto a robots.txt, crear el archivo con este plugin es igual de simple.

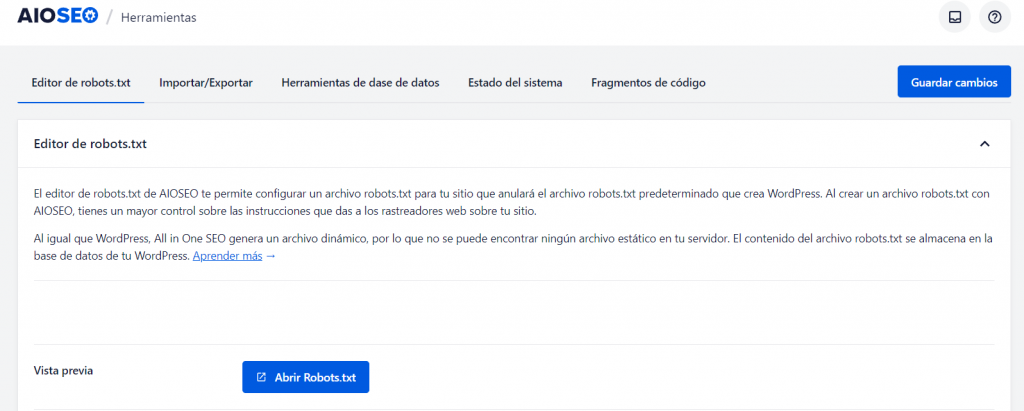

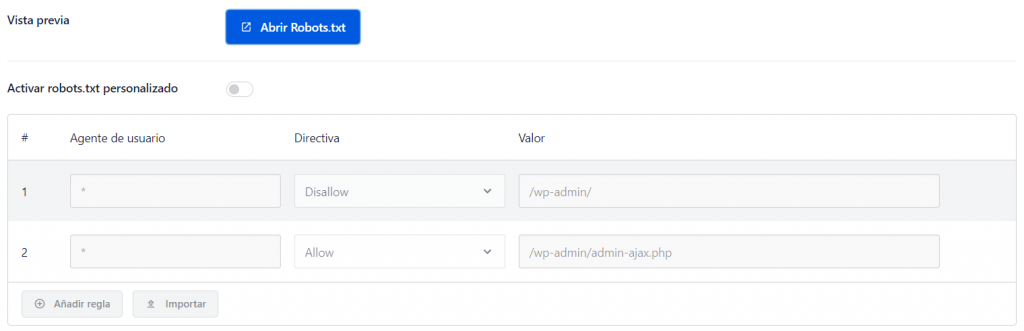

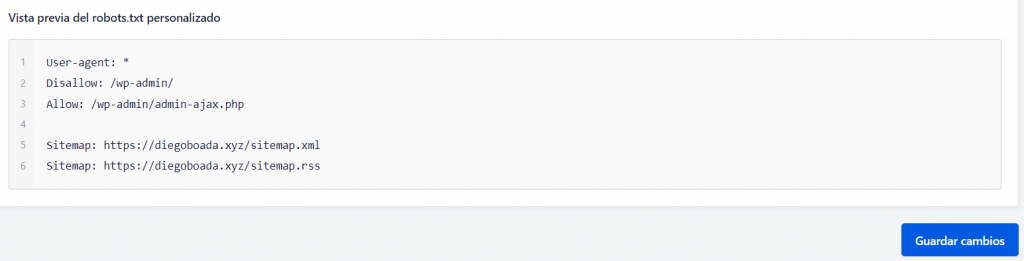

Una vez que hayas configurado el plugin, ve a la página All in One SEO > Herramientas en tu escritorio.

Ahora, aparecerá una nueva pestaña Robots.txt en tu menú All in One SEO. Si haces clic en él, verás opciones para agregar nuevas reglas a tu archivo, guardar los cambios que hagas o eliminarlo por completo:

Ten en cuenta que no puedes realizar cambios en tu archivo robots.txt directamente con este plugin. El archivo en sí está atenuado en gris, a diferencia de Yoast SEO, que te permite escribir lo que quieras:

En cualquier caso, agregar nuevas reglas es simple, así que no dejes que ese pequeño inconveniente te desanime. Lo que es más importante, All in One SEO Pack también incluye una función que puede ayudarte a bloquear robots indeseados, a la cual puedes acceder desde tu pestaña All in One SEO.

Eso es todo lo que tienes que hacer si eliges este método. Sin embargo, hablemos sobre cómo crear un archivo robots.txt manualmente, si no quieres configurar un plugin adicional solo para encargarse de esta tarea.

3. Crea y carga tu archivo robots.txt de WordPress a través de FTP

Crear un archivo txt es muy simple. Todo lo que tienes que hacer es abrir tu editor de texto favorito (como Notepad o TextEdit) y escribir un par de líneas. Luego puedes guardar el archivo usando el nombre que quieras y el tipo de archivo txt. Hacer esto toma unos segundos, por lo que tiene sentido que quieras editar robots.txt en WordPress sin usar un plugin.

Aquí hay un ejemplo rápido de un archivo:

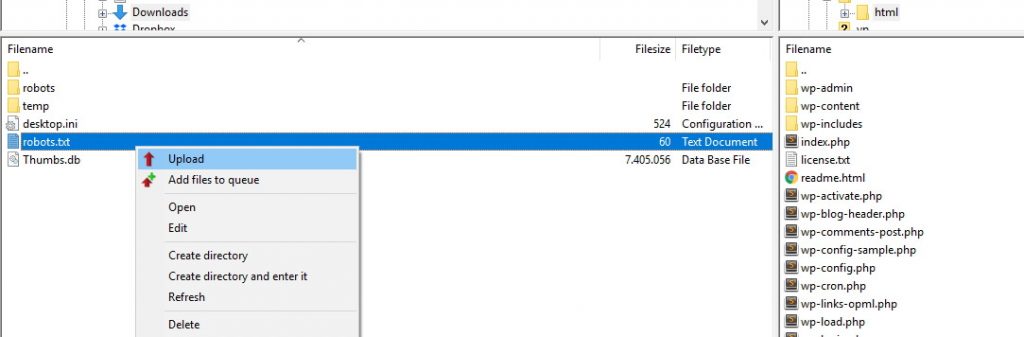

Para los propósitos de este tutorial, guardamos este archivo directamente en nuestra computadora. Una vez que hayas creado y guardado tu propio archivo, deberás conectarte a tu sitio web a través de FTP. Si no estás seguro de cómo hacerlo, tenemos una guía para hacerlo utilizando el cliente FileZilla.

Una vez que estés conectado a tu sitio, ve a la carpeta public_html. Entonces, todo lo que tienes que hacer es cargar el archivo robots.txt desde tu computadora a tu servidor. Puedes hacer eso haciendo clic con el botón derecho en el archivo utilizando el navegador local de tu cliente FTP, o simplemente arrastrándolo y colocándolo en su lugar:

El archivo solo debe tardar unos segundos en cargarse. Como puedes ver, este método es casi tan simple como usar un plugin.

¿Cómo probar el archivo robots.txt de WordPress y enviarlo a Google Search Console?

Una vez que hayas creado y cargado tu archivo robots.txt de WordPress, puedes usar Google Search Console para probarlo en busca de errores. Search Console es una colección de herramientas que Google ofrece para ayudarte a monitorear cómo se muestra tu contenido en los resultados de búsqueda.

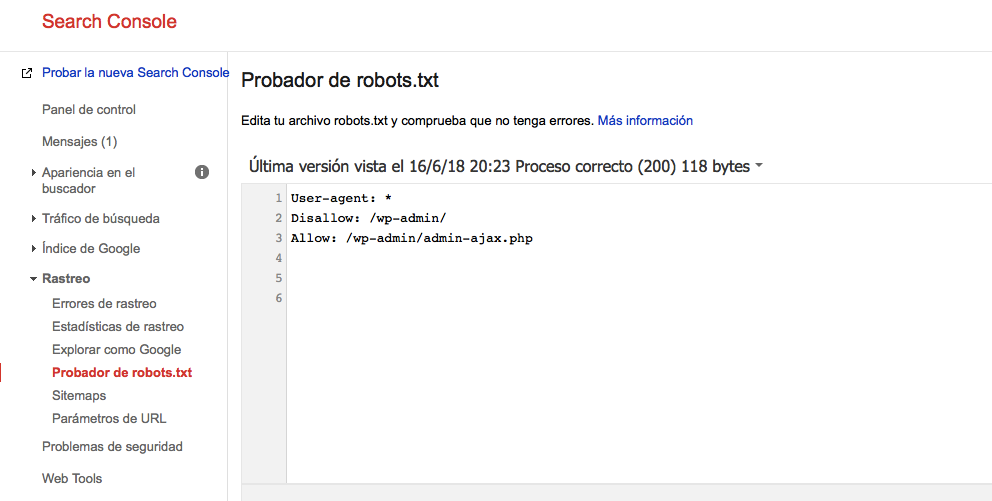

Una de estas herramientas es un verificador de robots.txt, que puedes utilizar iniciando sesión en tu consola y navegando a la pestaña de Probador de robots.txt bajo el menú “Rastreo”:

Adentro encontrarás un campo de editor donde puedes agregar el código del archivo robots.txt de WordPress y hacer clic en el botón Enviar justo debajo. Google Search Console te preguntará si quieres usar ese nuevo código o extraer el archivo de tu sitio web. Haz clic en la opción que dice Solicita a Google la actualización para enviarla manualmente:

Ahora, la plataforma verificará tu archivo en busca de errores. Si hay alguno, te lo mostrará.

Conclusión

Para aumentar la exposición de tu sitio web, deberás asegurarte de que los robots de los motores de búsqueda rastreen la información más relevante. Como hemos visto, un archivo robots.txt de WordPress bien configurado te permitirá determinar exactamente cómo interactúan esos robots con tu sitio. De esta forma, podrán mostrarle a los buscadores contenido más relevante y útil.

¿Tienes alguna pregunta sobre cómo editar robots.txt en WordPress? ¡Cuéntanos en la sección de comentarios!

Robots.txt en WordPress – Preguntas frecuentes

Aquí tienes algunas preguntas comunes sobre el robots.txt de WordPress.

¿Puedo desactivar robots.txt en WordPress?

No, no puedes desactivar robots.txt en WordPress, ya que es un archivo estándar que se utiliza para comunicarse con los motores de búsqueda y les indica qué páginas deben rastrear o no. Sin embargo, puedes modificar el contenido del archivo para controlar cómo interactúan los motores de búsqueda con tu página web.

¿Cómo puedo optimizar el robots.txt de mi sitio WordPress?

Puedes utilizar plugins como Yoast SEO para generar un archivo robots.txt con la configuración recomendada. También puedes modificar el archivo manualmente para controlar qué páginas y directorios bloquear o permitir que rastreen los motores de búsqueda.

¿Dónde está el archivo robots.txt en WordPress?

El archivo “robots.txt” se encuentra en la raíz de la instalación de WordPress, en el mismo directorio donde se encuentra el archivo “wp-config.php” y otros archivos principales de WordPress. Puedes acceder a este archivo utilizando un cliente FTP o en el Administrador de archivos en hPanel.

Comentarios

May 30 2019

Hola Gustavo gracias por tu articulo, lamentablemente yoast ha quitado su editor de archivos...

June 06 2019

En la versión actual de yoast encontrarás el editor para tu archivo robots en Herramientas>> Editor de archivos (es la segunda opción) Saludos.

June 17 2019

Hola Leonardo, gracias por tu aporte!